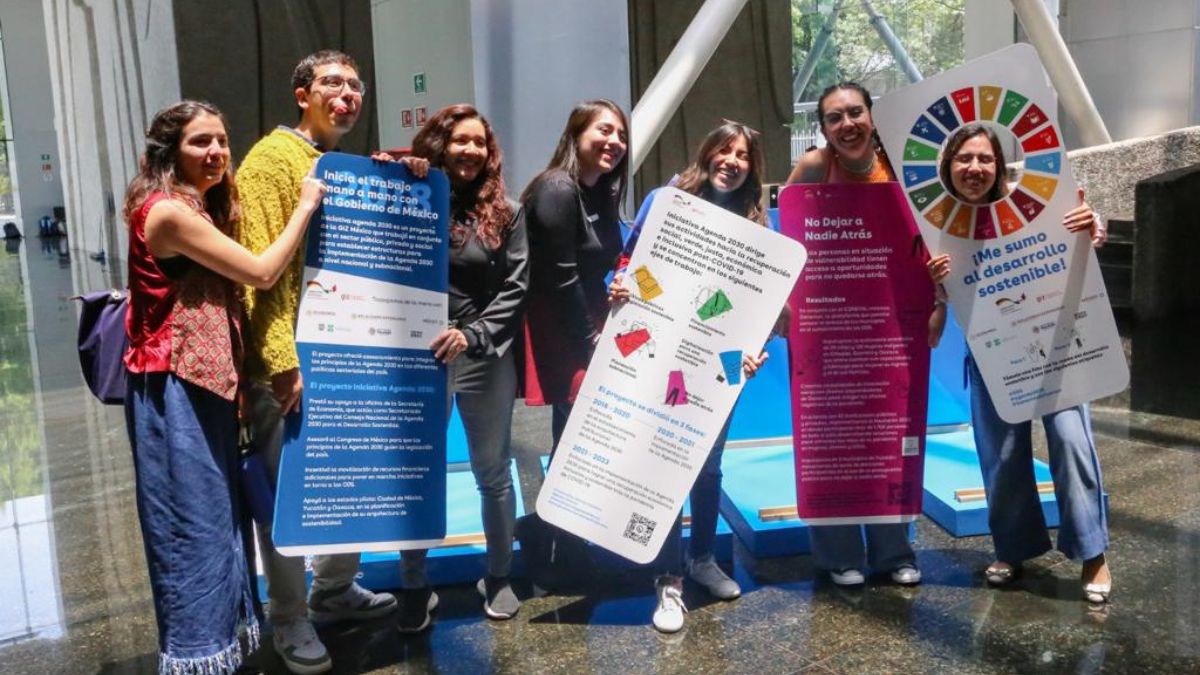

Fotografía: Cortesía

Líderes como Elon Musk y Steve Wozniak firmaron una carta que aboga por dejar de entrenar a los sistemas más avanzados de inteligencia artificial (IA), al menos por un tiempo.

Más de mil nombres de empresarios y expertos en tecnología aparecieron en una carta abierta que insta a detener el avance de los sistemas de IA más poderosos que existen. No sólo llamó la atención que se señalara que “pueden plantear riesgos profundos para la sociedad y la humanidad”, sino que entre quienes apoyan la iniciativa están el CEO de SpaceX, Tesla y Twitter, Elon Musk; el cofundador de Apple, Steve Wozniak; y la presidenta del Boletín de los Científicos Atómicos (encargado del Reloj del Juicio Final), Rachel Bronson.

La petición fue impulsada por la organización Future of Life Institute, que busca reducir los riesgos existenciales y catastróficos de las tecnologías poderosas. Por ello extendió la advertencia a los laboratorios de IA que “han entrado en una carrera fuera de control para desarrollar e implementar mentes digitales cada vez más poderosas, que nadie, ni siquiera sus creadores, pueden entender, predecir o controlar de forma fiable”.

El escrito enfatiza que las IA deberían progresar sólo cuando sus efectos sean positivos y sus riesgos manejables. Así, se sugiere que los experimentos con sistemas más potentes que GTP-4 (de OpenAI) esperen al menos 6 meses y durante la pausa se trabaje en protocolos de seguridad.

Un riesgo más presente

De acuerdo con The New York Times, mientras existe una comunidad online denominada “racionalista o “altruista efectiva” (dentro de la cual podría englobarse a Musk) que teme a una eventual destrucción de la humanidad por causa de las IA, hay otros académicos e investigadores que piden frenar un poco este progreso, pero por fallas más evidentes como la desinformación. Por ejemplo, se ha demostrado que sistemas como los GPT de OpenAI se equivocan o inventan datos, por lo que la atención debería estar quizás (por ahora) en cuidar que los seres humanos confíen demasiado en lo que contestan estas tecnologías.

Si te gustó esta nota y quieres saber más sobre recomendaciones, tips y noticias, suscríbete a nuestro newsletter de Máspormás y disfruta de la mejor información.